최준석 교수 연구팀, 최상위 국제학술대회 NeurIPS (The Thirty-Ninth Annual Conference on Neural Information Processing Systems) 2025 정규논문 채택

The Thirty-Ninth Annual Conference on Neural Information Processing Systems (NeurIPS 2025)

(왼쪽부터) 최준석 교수, 황동준 박사****과정, 김예진 석사과정, 이민영 박사과정

최준석 교수 연구팀 (황동준 박사과정, 김예진 석사과정, 이민영 박사과정)에서 수행한 지속 가능한 개방 어휘 분할 (Open-Vocabulary Segmentation, OVS) 모델 연구가 Neural Information Processing Systems (NeurIPS 2025) 에 채택되었다. NeurIPS는 인공지능 분야에서 세계적으로 권위 있는 학술대회로, BK 우수국제학술대회(인정 IF 4.0)로 등록되어 있으며, 오는 11월 30일부터 12월 7일까지 미국 샌디에이고와 멕시코시티에서 개최될 예정이다

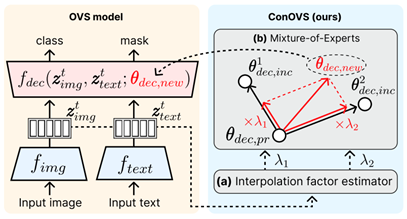

<****그림** **1. ConOVS** **방법론** **Overview>

이번 논문은 “OVS Meets Continual Learning: Towards Sustainable Open-Vocabulary Segmentation”이라는 제목으로, 추가 학습 데이터가 주어질 때 기존의 fine-tuning, retraining, continual learning접근법이 OVS 모델의 인식 능력을 충분히 확장하지 못한다는 한계를 지적한다. 대규모 데이터로 사전 학습된 foundation 모델과는 달리, 현재 OVS 모델은 그대로 활용하기에는 성능이 부족하다는 점도 함께 짚는다.

본 연구팀은 이를 해결하기 위해 OVS용 연속학습 프레임워크 ConOVS를 제안한다. ConOVS는 입력 샘플에 따라 디코더 가중치를 동적으로 병합하는 Mixture-of-Experts 전략을 사용한다. 새로운 데이터셋이 추가될 때마다 디코더를 경량 미세조정하고, 샘플 단위로 원본 모델과 전문가(Expert) 디코더 사이의 가중치 보간/병합을 수행해 성능 저하 없이 능력을 확장한다.

실험 결과, ConOVS는 다양한 비교군 대비 일관된 우수 성능을 보였다. 특히 데이터셋을 점진적으로 확장할수록 학습에 포함되지 않은 클래스가 존재하는 제로샷(Zero-shot) 테스트셋의 성능까지 함께 향상되는 경향을 확인했다. 이는 연속적 확장이 일반화 성능을 해치지 않고 오히려 강화할 수 있음을 보여준다.

본 연구는 OVS의 현실적 한계를 겨냥해 추가 데이터 수용성, 비용 효율성, 일반화를 동시에 고려한 학습 절차를 제시한다. 산업 및 학계에서의 지속 가능한 OVS 구축에 직접적인 기준점을 제공할 것으로 전망된다.

- 학회 페이지: https://neurips.cc/

**- 논문 링크: https://arxiv.org/abs/2410.11536

**